Data Warehouse

Ausgangssituation

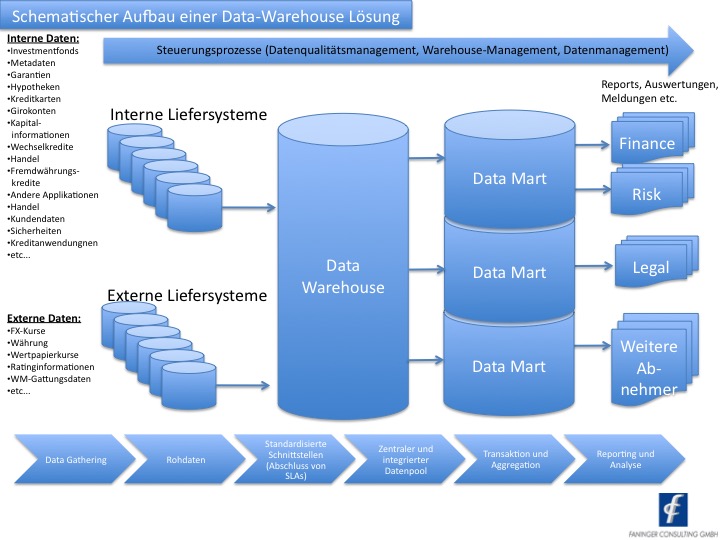

Ein Data Warehouse bildet eine zentrale Datenbasis, die für eine Reihe von Abnehmern im Unternehmen genutzt werden kann. Es dient zur Steuerung und Kontrolle von Geschäftsprozessen, bei denen Informationen die Basis von Management-Entscheidungen sind.

Die Einführung eines Data Warehouse beruht auf zwei Grundgedanken:

- Sammlung von Daten aus verteilten und unterschiedlich strukturierten Datenbeständen, um innerhalb des Data Warehouse eine gemeinsame Sicht auf die Daten – und damit die Möglichkeit für eine übergreifende Analyse – zu haben

- Trennung von operativen Systemen und zugehörigen Daten vom Data Warehouse; das Data Warehouse ist für die Analyse, das Reporting und zur Entscheidungsunterstützung bei der Geschäfts- und Risikoanalyse zuständig.

Aufbau – Layer-Architektur

Data-Warehouse-Architekturen sind aus einzelnen Layern aufgebaut. Daten werden zunächst aus diversen in- und externen Liefersystemen gesammelt und anschließend über mehrere Layer hinweg aufbereitet und standardisiert. Eine physische Datenbank stellt die integrierte Sicht auf die Daten dar, um Analysen zu ermöglichen:

Ein individuell konfigurierbares Datenmodell deckt für aufsichtliche Zwecke sämtliche Bestandteile der Gesamtbank ab und ermöglicht so eine einheitliche Auswertungsmöglichkeit von Daten.

Heutige Date-Warehouse-Architekturen sind in mehrfacher Hinsicht mit neuen Anforderungen konfrontiert, da zum einen die zunehmende Dynamik bei der Bankenregulierung (beispielsweise BCBS 239), die Dynamik im Business-Bereich, IT-Fortschritte und Technologie-Änderungen starken Einfluss auf Architekturen und Konzepte nehmen. Eine durchdachte Architektur und adäquate Methoden zum Auf- und Ausbau des Data Warehouse sind daher notwendig.

Damit verbunden sind jedoch auch Herausforderungen hinsichtlich der Konsistenz, der Flexibilität, redundanter Extraktionen und vielfältiger Datenmodelle. Auch handelt es sich oft nicht um einheitliche Technologien aus einem Guss, sondern um eine historisch gewachsen IT-Landschaft, die eine Vielfalt aus Werkzeugen, Programmiersprachen, Datenbanken und Tools beinhaltet, welche hohe Pflege- und Integrationskosten durch Technologiebrüche nach sich ziehen. Dies führt zu negativen Kostenimplikationen und beeinflusst die Flexibilität negativ.

In der Praxis haben sich daher Multi-Layer-Architekturen durchgesetzt, die ein auf das Unternehmen zugeschnittenes Konzept umsetzen. Dieses ist mehrschichtig in Ebenen aufgebaut und soll eine möglichst große Flexibilität gewährleisten. Eine einzig richtige Lösung gibt es trotzdem nicht, da unterschiedliche Anforderungen an die Leistungsfähigkeit, Ausprägung und Umsetzung gestellt werden, die je nach Institut individuell sind.

Extrahieren und Transformieren

Die strukturierte Datenhaltung und -aufbereitung ermöglicht es, die Daten der Bank über ETL-Prozesse (Extraktion – Transformation – Laden) genauestens zu analysieren und eine globale Sicht auf Informationen zu erhalten. So sind übergreifende Auswertungen vergleichsweise einfach möglich. Auch sind Systeme, die mehrschichtig aufgebaut sind, bereits flexibel aufgebaut, sodass neue Anforderungen schnell und flexibel umgesetzt werden können.

Data Mart

Ein Data Mart stellt eine Kopie eines Teildatenbestandes des Data Warehouse dar, die für einen bestimmten Abnehmer oder einen bestimmten Bereich erstellt wird. Es kann sich auch um eine Teilansicht des Data Warehouse handeln.

Ziel eines Data Marts:

- Zugriffe einschränken

- Eigenständigkeit der Anwender beim Zugriff auf einen Teilbereich von Daten (Unabhängigkeit, Geschwindigkeit etc.)

- Bessere Performance für den Teildatenbestand

- Durchführung von mehrdimensionalen Analysen (online analytical processing, OLAP)

Data Marts sind in Banken weit verbreitet. Allerdings ergeben sich auch Probleme aus der Nutzung von Data Marts:

- Welches ist der juristische Bestand?

- Wie ist die Abgleichbarkeit mit anderen Bereichen gewährleistet?

- Findet die Verarbeitung der Daten in den einzelnen Marts auf Basis von genehmigten Strategien und Policies statt?

Data Mining und OLAP

Data Mining und OLAP sind Methoden zur analytischen Datenanalyse von Endanwendern. Als zentrales Charakteristikum gewähren diese Tools mehrdimensionale Sichtweisen auf Datenbestände. OLAP soll es Nutzern ermöglichen, flexible und komplexe betriebswirtschaftliche Analysen und Ad-hoc-Auswertungen auch ohne umfassende technische Kenntnisse durchführen zu können.

Vorteile einer Data-Warehouse-Lösung:

- Transformation und Normierung der Ausgangsdaten in ein einheitliches Datenmodell

- Fachlich harmonisierte Datenhaltung und somit Basis für die Umsetzung von BCBS 239

- Abfragemöglichkeiten per SQL

- Kostenvorteil durch gemeinsame Nutzung eines Data Marts von verschiedenen Unternehmensbereichen

- Vergleichsmöglichkeiten über Zeitreihen hinweg

- Möglichkeit von Szenario- und Stressanalysen

- Relativ einfache Erweiterbarkeit

- Ermittlung verborgener Zusammenhänge zwischen Daten durch Data-Mining und somit Optimierung und Weiterentwicklung des Risikomanangements

- Transparenz hinsichtlich Geschäftsprozessen, Kosten und Ressourceneinsatz

- Automatisierte Informationsbereitstellung in Form von Reports oder Batch-Läufen

Unsere Leistungen

Wir helfen Ihnen bei der Implementierung einer BCBS 239-konformen Data-Warehouse-Lösung. Auch Fragestellungen, die sich im Rahmen von Überleitungsrechnungen, Abgleichbarkeit von Reports oder regulatorischer Datenkonsistenz ergeben, helfen wir zu lösen. Im Rahmen von Analysen unterstützen wir Sie dabei, Ihnen Handlungsbedarf zu identifizieren und Projekte erfolgreich umzusetzen.